先做个广告:如需代注册帐号或代充值Chatgpt Plus会员,请添加站长客服微信:pingzi7749

在人工智能领域,随着技术的进步,GPT系列模型已经发展到了GPT-5版本,这些模型以其强大的语言理解和生成能力而闻名,但随之而来的是对这些高级AI可能失控的担忧,我们将探讨GPT5是否会失控,并深入浅出地解释人工智能的安全性问题。

问题一:GPT5是什么?

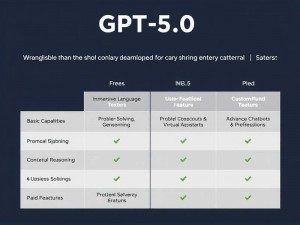

GPT5是一系列自然语言处理(NLP)模型中的最新版本,由人工智能研究实验室开发,这些模型使用深度学习和大量的数据集来训练,使其能够理解和生成人类语言,GPT5模型在理解上下文、生成连贯文本和执行复杂任务方面表现出了前所未有的能力。

问题二:GPT5有可能失控吗?

“失控”这个概念通常指的是人工智能系统的行为超出了开发者的预期和控制,对于GPT5这样的AI模型来说,它们的行为是由算法和训练数据决定的,开发者会采取严格的安全措施来确保模型的行为符合预期,包括但不限于:

1、伦理和安全审查: 在模型开发过程中,会有专门的团队对模型的潜在影响进行评估,确保它们不会被用于不当目的。

2、训练数据的质量控制: 通过精心挑选和过滤训练数据,减少模型学习到有害或不准确信息的风险。

3、行为限制: 通过编程限制,确保模型不会生成或执行违反法律和道德准则的内容。

问题三:如何确保GPT5的安全性?

确保GPT5的安全性是一个复杂的过程,涉及到多个层面:

1、透明度: 开发者需要公开模型的工作原理和限制,以便用户和监管机构能够理解其行为。

2、持续监控: 模型在实际使用中需要持续监控,以便及时发现并解决任何潜在问题。

3、用户反馈: 用户的反馈是改进模型和确保其行为符合预期的重要途径。

4、技术更新: 随着技术的发展,开发者需要不断更新和改进模型,以应对新出现的挑战和问题。

问题四:我们对GPT5的担忧是否过度?

对于人工智能的担忧在某种程度上是合理的,因为它们确实有能力对社会产生深远的影响,重要的是要认识到,开发者、研究人员和监管机构都在积极工作,以确保这些技术的安全和负责任的使用,通过不断的研究和改进,我们可以最大限度地减少风险,同时享受人工智能带来的便利和进步。

虽然GPT5等高级AI模型带来了新的挑战,但它们并不会“失控”,通过严格的安全措施和持续的研究,我们可以确保这些技术为人类带来积极的影响。

网友评论