先做个广告:如需代注册帐号或代充值Chatgpt Plus会员,请添加站长客服微信:pingzi7749

随着人工智能技术的飞速发展,GPT(Generative Pre-trained Transformer)模型已经成为了自然语言处理(NLP)领域的明星,作为GPT系列的最新成员,GPT-5以其强大的文本生成能力和理解能力吸引了全球的关注,GPT-5的原理究竟是什么?它又是如何工作的呢?本文将带你一探究竟。

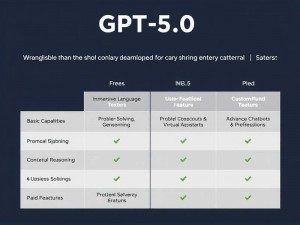

问题1:GPT-5是什么?

答:GPT-5是GPT模型系列中的第五代模型,它是一种基于深度学习的自然语言处理模型,能够理解和生成自然语言文本,GPT-5通过预训练和微调的方式,学习了大量的文本数据,使其能够理解语言的模式和结构,进而在各种NLP任务中表现出色。

问题2:GPT-5的工作原理是什么?

答:GPT-5的工作原理基于Transformer架构,这是一种用于处理序列数据的模型,特别适合处理自然语言,Transformer通过自注意力机制(Self-Attention)和前馈神经网络(Feed-Forward Neural Network)来处理输入的文本序列,自注意力机制允许模型在处理当前单词时,考虑到整个句子中的其他单词,这使得模型能够捕捉到文本中的长距离依赖关系。

问题3:什么是自注意力机制?

答:自注意力机制是一种计算输入序列中每个元素与其他元素之间关系的机制,在GPT-5中,自注意力机制通过计算每个单词与其他所有单词之间的相关性来实现,这种机制使得模型能够识别出文本中的不同部分之间的关系,比如主题、上下文和语法结构。

问题4:GPT-5如何进行预训练?

答:GPT-5的预训练过程涉及大量的文本数据,模型通过这些数据学习语言的基本模式和结构,预训练通常包括两个阶段:掩码语言模型(Masked Language Model, MLM)和下一句预测(Next Sentence Prediction, NSP),在MLM任务中,模型需要预测被随机掩盖的单词;在NSP任务中,模型需要预测两个句子是否是连续的,这些任务帮助模型学习语言的上下文和连贯性。

问题5:预训练后如何进行微调?

答:预训练完成后,GPT-5可以通过微调来适应特定的NLP任务,微调是在特定的数据集上进行的,这些数据集与目标任务相关,通过微调,模型可以调整其权重,以更好地执行特定任务,比如文本分类、问答系统或者机器翻译。

问题6:GPT-5有哪些应用场景?

答:GPT-5的应用场景非常广泛,包括但不限于:

- 文本生成:自动撰写文章、生成创意文案等。

- 聊天机器人:提供客户服务、在线支持等。

- 语言翻译:实现不同语言之间的自动翻译。

- 文本分析:情感分析、主题分类等。

- 教育辅助:智能教学、个性化学习等。

问题7:GPT-5的优势和局限性是什么?

答:GPT-5的优势在于其强大的语言理解和生成能力,以及能够处理大量数据和复杂任务的能力,它也存在一些局限性,

- 可解释性:GPT-5的决策过程往往是黑箱操作,难以解释其为何做出特定预测。

- 偏见和错误:模型可能会从训练数据中学习到偏见,导致不准确或不公平的预测。

- 资源消耗:GPT-5需要大量的计算资源进行训练和运行,这限制了其在资源受限的环境中的应用。

问题8:未来GPT-5的发展方向是什么?

答:GPT-5未来的发展方向可能包括:

- 提高可解释性:研究如何使模型的决策过程更加透明和可解释。

- 减少偏见:开发新的训练方法和技术,以减少模型从数据中学习到的偏见。

- 优化资源消耗:通过模型压缩和优化技术,降低模型的计算需求。

- 跨模态能力:将GPT-5扩展到视觉、音频等其他模态,实现更丰富的交互和应用。

GPT-5作为GPT系列的最新成员,其原理基于Transformer架构,通过自注意力机制和预训练-微调流程,展现出了卓越的语言理解和生成能力,尽管存在一些局限性,但GPT-5的应用前景广阔,未来的发展方向也令人期待,随着技术的不断进步,GPT-5有望在更多领域发挥重要作用。

网友评论